Blog

Nossa Black Friday 2023

Você não achou que ficaríamos de fora né? Cloud Native .NET, Mensageria .NET e ACADEMIA DEV - O...

Cloud Native .NET com .NET Aspire – Primeiras Impressões

Um dos lançamentos do .NET Conf foi o .NET Aspire. Ele é um orquestrador de recursos (containers...

Keyed DI services e Como o uso de tipos como identidade penaliza o design

Nos últimos anos vimos muitas implementações que usam Tipos (classes ou interfaces) como...

Porque as empresas vão continuar buscando seniors ao invés de júniores?

O apagão na TI é um fenômeno real, mas um fenômeno bem estranho do nosso mercado é a distância...

Bloqueio do Telegram – SITREP 02 – Quem vai pagar essa conta é você!

Hoje somos dezenas de milhares de profissionais de tecnologia amontoados em grupos do telegram....

Bloqueio do Telegram – SITREP 01 – Situação e Plano de ação

O bloqueio do telegram está causando histeria na comunidade técnica e em grupos privados. Aqui vou...

Event Driven Architecture – Lançamento de Módulo

Enfim um dos mais esperados conteúdos do curso de RabbitMQ está no ar. Event Driven Architecture....

Os 6 níveis de maturidade no uso de Containers

Do usuário eventual ao heavy user, Docker consegue entregar diversas experiências de acordo com...

Além das 3 camadas | Containers

Docker está para o desenvolvimento de software como o IPOD esteve para a indústria da música. Não...

RabbitMQ, .NET, OpenTelemetry, Distributed Tracing, Jaeger, Prometheus e Grafana

Parece sopa de letrinhas aleatórias né? Mas isso fez algum sentido para você, e achou legal, deixa...

RabbitMQ | Eficiência | Como jogar dinheiro fora, case da Digital Ocean

A Digital Ocean é um Cloud Provider famoso e muito usado no mundo todo, mas nem por isso deixaram...

Cloud Native .NET – Um overview sobre as mudanças

É com muita felicidade e um frio na barriga que anuncio as mudanças para 2022 aqui no gaGO.io. A...

Event Driven Or Not? Quando usar Event Driven e quando usar só usar mensageria

Sempre que somos tocados por algum tipo de desenho ou arquitetura que demonstra significativo...

Além das 3 camadas | Componente: CDN e Cache

Já falamos de práticas e tecnologias, agora vamos falar de um componente o CDN. Ele é fundamental...

Concorrência e Race Condition com Cache Distribuído: O Workflow correto

Se você está vendo cache distribuído pela primeira vez, talvez tenha deduzido qual é a forma...

Além das 3 camadas | Prática: Reduzindo pressão sob a aplicação e banco

Nessa série de posts estamos furando a bolha, saindo do desenho básico de 3 camadas, indo além....

Além das 3 camadas | Ferramenta: Redis

Nessa série de posts estamos furando a bolha, saindo do desenho básico de 3 camadas, indo além....

Além das 3 camadas | Iniciando os trabalhos

Se um dia você se questionou sobre o que deveria estudar sobre projetos que vão além de uma Web...

Processamento Síncrono vs Assíncrono e Black Friday – Case Pan, Kabum e Pichau 2021

Essa noite aconteceu uma coisa muito chata. Em plena Black Friday, eu saí frustrado por 2...

Overengineering, BDUF, Complexidade Acidental? Por que estamos usando tantas ferramentas, tecnologias etc?

Se você está nesse planeta ativo em alguma comunidade deve ter percebido que todo dia surge uma...

A jornada do Arquiteto .NET | Docker Definitivo / O ROADMAP

Todos os dias usamos os grupos técnicos para perguntar: Como fazer X, como fazer Y. Mas você já se...

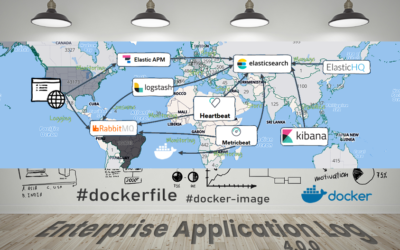

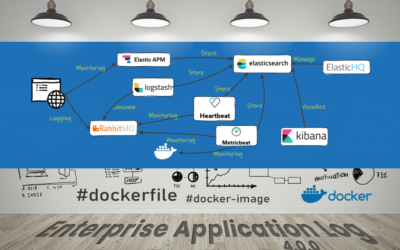

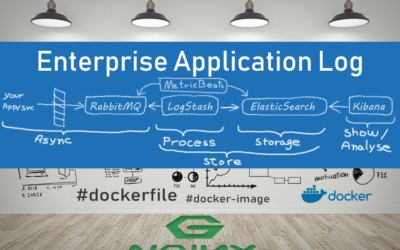

Enterprise Application Log – A origem das decisões

Inúmeras vezes eu apresento o Enterprise Application Log e instantaneamente aparece alguém...

Docker Definitivo – Inscrições dias 11 e 12 de Novembro

Após um longo inverno, teremos mais uma janela de inscrição para o Docker Definitivo! Esse é o...

NHibernate em 2022 – Será que faz sentido?

Se você já me viu falar de persistência, você talvez já saiba do que eu estou falando, mas talvez...

RPC sob AMQP seduz enquanto mata… sua implantação de mensageria

Se você viu meu último post e se animou por acreditar que usar RPC sob AMQP seja uma ideia...

Messaging Patterns: RPC – Remote Procedure Call

RPC pode parecer sofisticado demais, mas que tal Request/Response? Agora "SOA" familiar? Nem só de...

O que aprendi acompanhando projetos sem arquitetos

Esse é um relato dos meus 20 anos no mercado. Por sorte e até ironia do destino, eu vi o papel do...

17 ações que você pode fazer hoje, para fracassar seu projeto amanhã

Hoje vamos de dicas para o caos e a destruição. É a atitude pessimista que dá emprego para mais...

Resiliência: Polly vs RabbitMQ

Fato que eu adoro essas comparações inusitadas! A intenção desse post é poder trazer de forma...

Porque Injeção de Dependência importa?

Algumas coisas são feitas no automático, e se você não entendeu porque o ASP .NET usa Injeção de...

Projetos Open Source

projetos ativos e projetos antigos disponíveis para estudo

Nenhum resultado encontrado

A página que você solicitou não foi encontrada. Tente refinar sua pesquisa, ou use a navegação acima para localizar a postagem.

Docker FAQ by gaGO.io

Se você está dando seus primeiros passos com Docker ou quer começar, esse é um post de "boas...

RabbitMQ e Kubernetes | Rivais ou Aliados?

Se, ambos, RabbitMQ e Kubernetes promovem um melhor uso de sua infraestrutura, trazem resiliência,...

RabbitMQ é Resiliente? [video]

Será que o RabbitMQ de fato é seguro? O que acontece quando ele cai? O que acontece se minha...

Streams no RabbitMQ

Uma novidade que vai deixar aqueles que ficavam comparando RabbitMQ e Kafka mais perdidos ainda....

Kafka vs RabbitMQ

Vamos direto ao ponto: São coisas diferentes, se você está comparando ambos ou está querendo...

RabbitMQ para Aplicações .NET – a MasterClass virou Curso

Em 2013 eu tinha o desafio de processar milhões de músicas. Eu não tinha uma restrição de tempo,...

MVP | Developer Technologies | 2021-2022

A terceira nomeação chegou!!!! É sempre um momento de muita gratidão. É sempre momento de olhar...

SQL Server 2017 e 2019 +Automações | Update JUN/2021

Desde julho de 2018 quando produzi a primeira versão dessa imagem, muita coisa aconteceu. Eu...

Entendendo RabbitMQ #2 – Caso de Estudo – Envio de Emails

Essa segunda série de posts sobre RabbitMQ visa mostrar como podemos usar RabbitMQ em cenários que...

Você sabe se escolheu o data center certo?

Na jornada de criar aplicações globais, o arquiteto precisa prover dados que guiem as estratégias...

Entendendo RabbitMQ #1 – Reduzindo e/ou Eliminando Acoplamento

Ao esbarrar com uma nova tecnologia, você pode se perguntar: Será que é para mim? Com RabbitMQ não...

Tutorial: Trabalhando com Secret Files no Jenkins Pipeline

Você já se perguntou como usar arquivos de configurações sensíveis em pipelines de CI/CD sem que...

Enterprise Application Log v4

Hoje chegamos à versão 4 do nosso stack de observabilidade. Contamos com o upgrade para a versão...

EasyNetQ em perspectiva

Abstrações são desenhadas para resolver problemas e abstrair um ou mais aspectos de uma...

Docker Definitivo – Turma de Abril/2021

Afinal é para dev? É para DevOps? É para Ops? O que é essa bagaça? Vamos falar sobre isso hoje....

Arquitetura de Software – 10 anos de Facebook

No dia 1° de Abril de 2011 eu fundei um grupo de arquitetura que amanhã, no último dia 1°...

Entrypoint vs CMD – v2 – Conteinerizando o Kubectl

Se você precisa interagir com um cluster kubernetes, você já deve ter ouvido falar do Kubectl (o...

Habemus Kubernetes

Hoje eu estou muito feliz por fazer esse anúncio por aqui. Oficialmente estamos subindo as...

Hub de Eventos

Na quinta-feira, dia 18/Março/2021 vamos falar do Hub de eventos que produzi para atender uma...

MongoDump e MongoRestore com Docker

Recentemente produzi a Jornada Dev Pro e foi um evento que teve uma aplicação de suporte. Embora...

.NET Microservices Architecture Guidance | 3 Ebooks Gratuitos

A abundância de conteúdo descentralizado e a velocidade com que o mercado avança gera desconforto...

Publish com VS em produção: Impactos e Consequências

A Microsoft sem sombra de dúvidas é uma empresa com um foco incrível no desenvolvedor. Diariamente...

A Jornada DEV PRO

Ao longo dos últimos anos eu vi muitos desenvolvedores batendo cabeça, cada do seu jeito. Não...

O CÓDIGO – SEXTA – 15/JAN

8:30 - Dicionário Docker - Entendendo esses nomes novos Container, Imagem, Kubernetes, Docker,...

Kubernetes em C#, seria possível?

Você já pensou em criar seu próprio Kubernetes em C#? Hoje eu vou mostrar como você pode dar os...

O CÓDIGO – QUINTA – 14/JAN

8:30 - Poltys - Decisões de Arquitetura de um Web Crawler. Hoje eu vou detalhar algumas decisões e...

RabbitMQ – Guia de Estudo Gratuito 2021

RabbitMQ é simples e incrível. São apenas 4 componentes. Relativamente simples, mas cada um tem...

Docker Definitivo – Última turma 2020

Quando eu idealizei o Docker Definitivo eu me propus a resolver, em escala, um problema que eu...

Kubernetes sem Docker! É o fim do docker?

Ontem a comunidade parou diante da notícia de que o Kubernetes não daria mais suporte ao Docker...

Service Mesh vs API Gateway vs Proxy Reverso

Durante a live de kong da semana passada rolou uma dúvida bem pertinente, mas como a live já...

De Docker Definitivo para Cloud Native .NET

Nada muda por dentro, mas tudo muda por foraSabe quando você está escrevendo código e dá um nome ruim para uma classe ou um método, ou mesmo para um projeto ou library? Pois bem, Docker Definitivo foi um desses nomes errados.

Por dentro Docker era apenas uma fração, o ponta-pé inicial do curso e por mais que eu tentasse expressar o que víamos aqui dentro para quem estava do lado de fora, eu simplesmente não conseguia.

Agora temos um nome que representa o que fazemos aqui!

Seja bem vindo Cloud Native .NET!

Cloud Native expressa esse desenho de solução projetado para a cloud, sem apego a nenhum cloud provider.

.NET expressa o foco e o compromisso com o desenvolvedor .NET, minha tribo.

Abstrações duplicadas, quem nunca?

Quando uma abstração está exercendo seu papel, seu código tende a cada vez parecer mais simples. Ao olhar desatento pode parecer até simplista. O problema é que essa simplicidade ao mesmo tempo que aumenta a produtividade, produz ansiedade e afeta quem depende de...

Abstrações e seu ciclo evolutivo

Uma das ideias que tenho amadurecido ao longo dos últimos anos está ligado às implementações de mecanismos arquiteturais e abstrações. Em Abstrações – Tradeoffs e co-responsabilidade eu falei sobre o que são abstrações boas, abstrações ruins, ponderei sobre quando...

Be Welcome .NET 5

É incrível ver que mesmo diante do dilema de uma mudança abrupta de rotina, o calendário de Releases do .NET 5 se manteve intacto. Temos uma mudança incrível na plataforma e enfim chegou o .NET 5! O Release Candidate 2 do .NET 5 já é SUPORTADO EM PRODUÇÃO pela...

Register/Resolver e suas implicações para a modelagem e reaproveitamento

Você já notou que desde a chegada do .NET Core, consistentemente reaproveitamos menos nossas classes, principalmente de infraestrutura. Escrevemos mais classes e cada vez reaproveitamos menos nosso código? Bom se você não notou isso, então ao invés de 1 problema,...

Como perder mensagens com RabbitMQ

É comum falarmos sobre receitas de sucesso e como resolver problemas, mas será que você está fazendo essas coisas, está perdendo mensagens e vai culpar o RabbitMQ por isso? Se liga nessas dicas, pois se você está perdendo mensagens com RabbitMQ, a culpa é totalmente...

Enterprise Application Log + Access Log NGINX

Embora esse tutorial trate detalhadamente de configurações do NGINX e LogStash, no lugar do NGINX você pode usar qualquer aplicação que produza log em textos e que seja possível manipular o formato dos logs. Passo 1 - Escrever o log em formato JSON Nesse passo vamos...

Ring Buffer – Antecipe, otimize e evite custos excessivos

Ring Buffer, também chamado de Circular Buffer é uma estrutura de dados muito poderosa. Seu nome já traz o spoiler e entrega o ouro, afinal não deixa de ser um buffer, só que trabalhando em formato de anel/circular. Se você não faz ideia do que seja, vem comigo nessa...

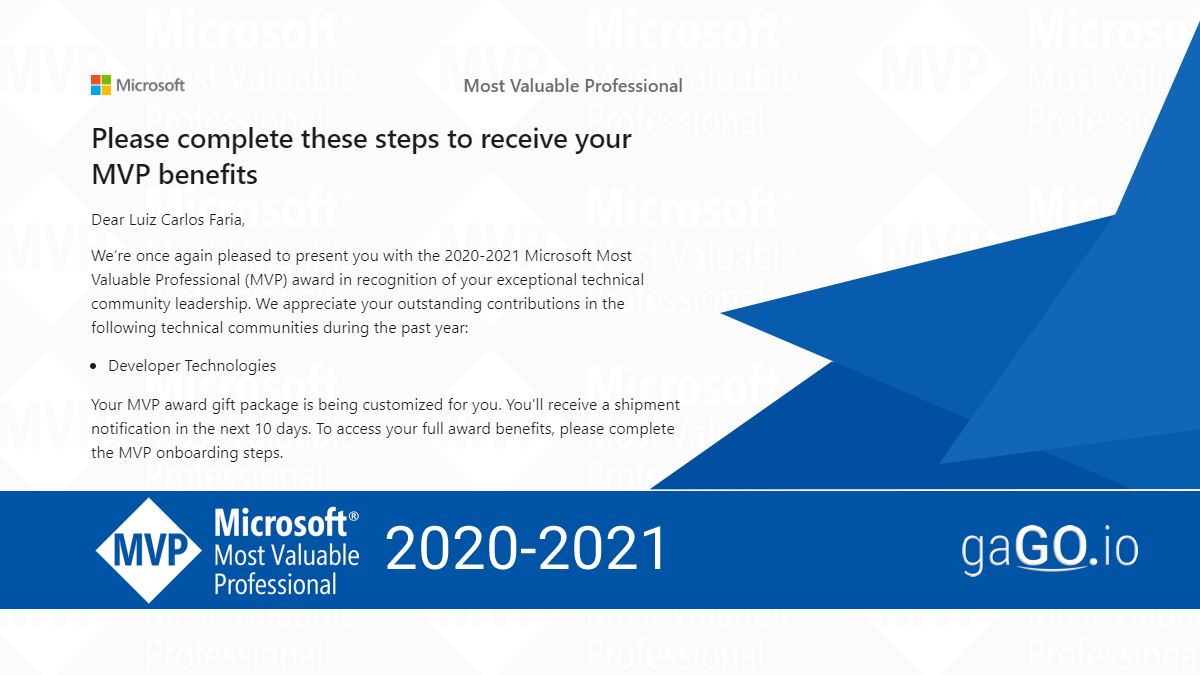

MVP | Developer Technologies | 2020-2021

Em Outubro de 2018 eu recebi o primeiro prêmio Microsoft Most Valuable Professional! Como faltava pouco para a renovação (maio, com resultado em 1° de julho) minha renovação havia sido marcada para 2020. E agora estou aqui para contar um pouco sobre o programa e essa...

Azure Functions + Containers (Parte 2/2)

No post passado o foco estava nos Agnostic Services e no uso de containers. Agora é hora de olharmos outra questão mais braçal. Rodar Azure Functions 3 com Containers, uma tarefa que deveria ser trivial, mas não é. Nossa jornada começa com o tutorial Criar uma função...

Azure Functions + Containers (Parte 1/2)

Certa vez rolou uma discussão sobre Function as a Service (FaaS) e Containers questionando se um suplantaria o outro, ou se seríamos capazes de ignorar um em função do outro. Minha resposta curta e objetiva é: Não! Functions e Containers se complementam. Sempre que...

Dockerfiles: Entrypoint vs CMD?

Você viu Entrypoint e CMD em algum lugar, seja em um dockerfile ou em um docker run, mas não faz a ideia do que seja? Vem comigo, é mais simples do que você imagina. Esse é o típico cenário em que a resposta é mais idiota do que você possa imaginar. É algo que não é...

Comunidade Solidária Microsoft

Tudo bem aí? Tá sabendo da Semana Nacional de Tecnologia? Nessa segunda-feira começou a Semana Nacional de Tecnologia. Sob o slogan "Usando conhecimento para transformar o mundo". Antes de mais nada, o que vem a ser esse evento? É gratuitoÉ onlineTransmitido via...

Docker no WSL² – Walkthrough

No post anterior eu contei um pouco da história do projeto, mas agora é hora de olharmos para ele de fato. Que tal um passeio no parque com o WSL2? Enfim Generally Available do WSL2 que chega ao Windows 10 na versão 2004 Esse texto era parte do post anterior Enfim...

Enfim Generally Available do WSL2 que chega ao Windows 10 na versão 2004

A maior expectativa que eu tinha nos últimos anos era esse lançamento: WSL2 em Generally Available. Ficou fantástico! Antes de falarmos de WSL2 precisamos falar de WSL e do WSL1 e sua história na Microsoft. Um pouco da história do WSL WSL1 chega no Microsoft Build...

Tesseract OCR + ASP.NET Core

Esse projeto nasceu de uma iniciativa de combate a SPAM. Spammers no telegram usam novas táticas todos os dias e corrida de gato-e-rato nos faz usar tecnologia para sanar e bloquear as iniciativas desses spammers. Eu particularmente sou extremamente ativo no telegram,...

Docker Definitivo – Gravação de Aula

Meus queridos, preciso gravar aulas para a turma do Docker Definitivo, estamos na reta final. Algumas delas serão gravadas online com transmissão no youtube, porém, não serão gravadas. Por conta da qualidade, e do modelo, será apenas uma transmissão sem...

A mecânica das decisões

Chegou a hora de avaliarmos o mercado, a situação na qual estamos e entender quais movimentos são possíveis. Entender friamente o que pode acontecer e quais são os movimentos possíveis nesse tabuleiro, nos permite antecipar ações para minimizar os efeitos de sermos...

Live Coding – Coravel Application Framework

Pessoal, vamos animar essa quarentena? Essa é a primeira vez que vamos fazer isso e vamos construir essa dinâmica juntos. Eu preciso da sua participação e sua ajuda para definir o roadmap, mas por hora vamos falar sobre tecnologia e ver no que dá! Não tem pauta...

Jornada DevHero – REPRISE

Em janeiro de 2019 produzi um evento chamado Jornada Dev Hero. A jornada do desenvolvedor, mostrando o caminho que eu e diversos amigos trilhamos para chegar onde chegamos. Eu achei o conteúdo tão rico e tão importante em termos de mensagem e capacidade de...

.NET no Linux, vale a pena?

A gente está a tanto tempo nessa batida, que nem nos questionamos mais, mas há muita gente que ainda tem dúvidas ou precisa de argumentos. Enquanto de um lado sequer cogitamos fazer deploy de aplicações .NET Core no Windows, por outro há quem ainda tenha medo de sair...

Docker Definitivo – Updates

Esse aqui é um post para quem está interessado no curso e têm perguntado a respeito do treinamento. Docker Definitivo emerge do Docker de A a Z. Enquanto no Docker de A a Z eu uso para falar de coisas que gosto e estou vendo no dia-a-dia do uso de Docker, percebi que...

O dado é do usuário, não é seu, nem do sistema!

Parece um conceito banal, mas vou contar uma história atual, muito recente e vou contar o reflexo disso operacionalmente. É mais um daqueles casos em que a "boa vontade" é traduzida em processo e procedimentos equivocados que geram mais problemas do que soluções. O...

Do WCF para ASP.NET Core Web API com Docker no Linux 2/2

Agora é hora de mostrar como podemos tirar proveito dos contratos (interfaces) existentes para promover essa migração. Esse é o momento em que a "SOPA de LETRINHAS" ou melhor, os design patterns fazem sentido. Graças a eles, essa migração que poderia ser dolorosa e...

Do WCF para ASP.NET Core Web API com Docker no Linux 1/2

Não sei se você conhece WCF, rodando uma enquete eu percebi que uma parcela considerável sequer conhece WCF. Hoje vamos costurar o assunto com um outro post para que eu possa mostrar como fazer uma migração de WCF pra Web API no ASP.NET Core, rodando em containers...

Sobre 1° de Agosto e o Fim do Hangouts On Air – Como resolvemos com Docker, NGINX e RTMP no Azure Container Instances

1° de agosto de 2019 foi um dia agitado. Fomos surpreendidos com a ausência do Google Hangouts On Air, mas logo reagimos às mudanças com uma solução baseada em Azure Container Instances, NGINX, Docker para fazer streaming a 60FPS em 1080p!!! Streaming gamer para live...

Docker Definitivo – Janela de Inscrição – JAN/2020

Todo os dias tomamos decisões das mais variadas. Dormir mais 5 minutos, pegar o celular antes de dar bom dia, fazer café? Será que dá tempo? Tomar café na rua? Ah! Maldito café de máquina! Que caminho tomar? Carro, metro, trem ou ônibus? Prestar atenção na paisagem ou...

Troubleshooting Comentado – Docker – ASP.NET Core – NGINX

Já faz muito tempo que eu queria fazer esse formato. Documentar uma ação qualquer de troubleshooting na comunidade para poder transformar em conteúdo, fazendo pausas didáticas e interrupções para poder contextualizar no formato de quebra da 4ª parede. O Felipe...

Angular + Docker no Heroku

Heroku é um daqueles serviços de hospedagem à frente do seu tempo. É pioneiro em desenhar um modelo com foco total no desenvolvedor. Uma Heroku é uma plataforma que te dá a possibilidade de hospedar aplicações a um preço muito competitivo. Exploramos o uso de Docker...

Habilidades do futuro?

De um lado as guerras dos frameworks e tecnologias, de outro as guerras de skills e culturas. Cultura DevOps, Agile. Então serverless ou containers? Fullstack é um pato que não corre bem, não nada bem, e não voa bem? Aproveitei essa noite para reler as pesquisas que...

Rebranding

Hora de acertar a casa, rever os nomes, marcas, páginas, perfis, grupos, tudo! Fim de ano chega e está na hora de rever o que está certo, o que está errado, hora de planejar o próximo ano. No meu caso também errei e também fiz uma lambança com marcas, projetos....

Nenhum resultado encontrado

A página que você solicitou não foi encontrada. Tente refinar sua pesquisa, ou use a navegação acima para localizar a postagem.

Conteúdo Gratuito

Tudo que está aqui no gaGO.io é conteúdo gratuito, feito para ajudar desenvolvedores dos mais variados níveis.

Cursos

Tenho também alguns programas de acompanhamento. Esses programas tem a função de ajudar desenvolvedores em áreas específicas ou de forma mais abrangente na jornada do arquiteto.

![RabbitMQ é Resiliente? [video]](https://gago.io/wp-content/uploads/2021/07/rabbitMQ-youtube-400x250.jpg)